Unidad 1.3. Inicios y evolución de la IA.

El nacimiento de la IA

Texto en la placa conmemorativa de la conferencia de Dartmouth: "Primera utilización del término "Inteligencia Artificial". Fundando la Inteligencia Artificial como una disciplina de investigación para proceder sobre la base de la conjetura de que cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, describirse tan precisamente que se puede construir una máquina para simularlo".

A partir de los años 50 se produce una evolución explosiva de la IA aunque con altibajos, también llamados inviernos de IA. El resumen de tal proceso se presenta en esta imagen.

Desde la histórica conferencia de Dartmouth en 1956, que marcó el inicio formal de la Inteligencia Artificial (IA) como campo de investigación, hasta el año 2011, se han producido importantes avances en la evolución de la IA. Los impulsores de la conferencia de Dartmouth fueron: John Mcarthy (Dartmoth College), Marvin L. Minsky (MIT), Nathaniel Rochester (IBM, y Claude Shannon (Laboratorios Bell). Cada uno de ellos era líder en áreas cruciales para el nacimiento de la IA. McCarthy en la formulación de conceptos de IA, Minsky en el aprendizaje de máquinas y redes neuronales, Rochester en hardware y arquitectura de computadoras, y Shannon en teoría de la información. Sus conocimientos y colaboraciones fueron fundamentales para establecer una base sólida que permitió el desarrollo y crecimiento de la IA como una disciplina de investigación.

A partir de ese momento, y creciendo sobre los cimientos de las teorías, desarrollos conceptuales y tecnológicos acumulados hasta ese momento, se fueron sucediendo logros técnicos y tecnológicos que han desembocado en la irrupción aparentemente imparable de la IA en la actualidad.

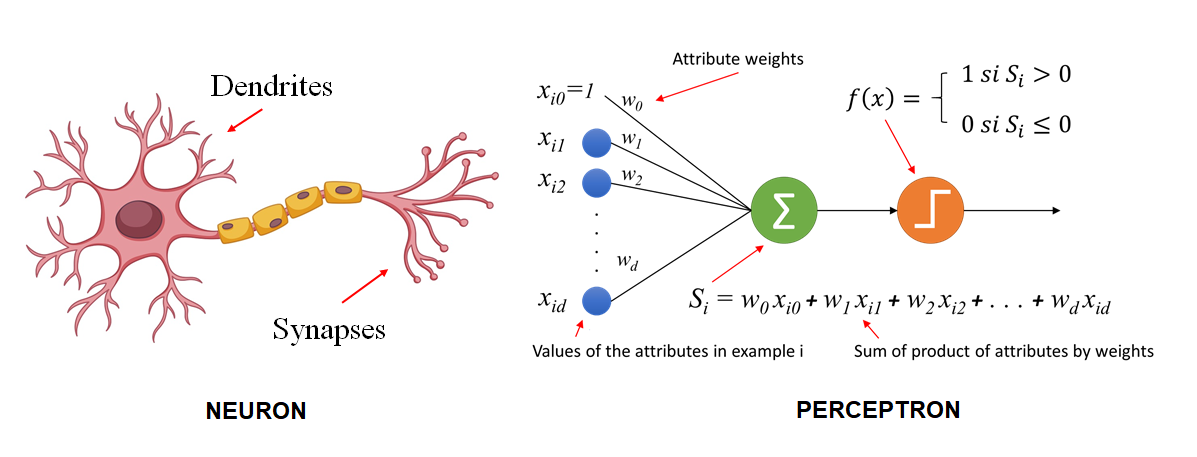

Uno de los hitos clave fue la invención del perceptrón por Frank Rosenblatt en 1957. El perceptrón fue uno de los primeros modelos de aprendizaje automático inspirados en las redes neuronales del cerebro humano. El perceptrón, era una evolución de la neurona McCulloch-Pitts, si bien mejoraba a esta al introducir el concepto de aprendizaje automático. Mientras que la neurona de McCulloch-Pitts tenía pesos fijos, el perceptrón permitía el ajuste de los pesos en función de los datos de entrada a través de un proceso de aprendizaje simple, lo que permitía que el modelo aprendiera a clasificar diferentes patrones de datos automáticamente. Esta capacidad de aprender de los datos fue un avance significativo hacia el desarrollo de algoritmos más avanzados de aprendizaje automático y redes neuronales.

Seymour Papert, que trabajó junto con Marvin Minsky y ambos fueron coautores de un libro muy influyente llamado "Perceptrons" en 1969, que exploraba las limitaciones y las capacidades de los perceptrones y las redes neuronales. Su trabajo junto con Minsky fue crucial para entender y analizar las capacidades y limitaciones de estos modelos, lo cual fue fundamental en el desarrollo temprano de la inteligencia artificial y el aprendizaje automático.

"El perceptrón es el embrión de una computadora que será capaz de hablar, caminar, ver, escribir, reproducirse y ser consciente de su existencia" Seymour Papert

Comparativa gráfica entre una neurona y el perceptrón. https://inteligenciafutura.mx/english-version-blog/blog-06-english-version

Sin embargo, a pesar de sus prometedoras capacidades, pronto surgieron limitaciones y desafíos que llevaron a un declive en la investigación de la IA, conocido como el "primer invierno de la IA". La citada publicación "Perceptrons" en la que también se mencionaban las limitaciones del mismo anticipó ese declive.

En el "primer invierno de la IA", que tuvo lugar durante la década de 1970 y principios de la década de 1980, los avances en la IA se estancaron debido a la falta de resultados prácticos y las expectativas excesivas. El financiamiento se redujo y muchos investigadores abandonaron el campo.

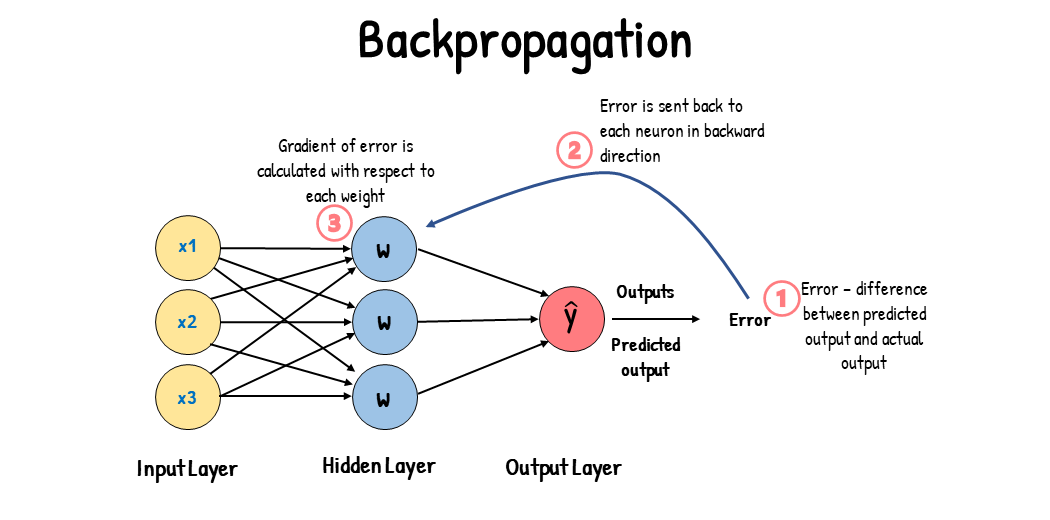

Si bien, aún sin financiación a gran escala, los trabajos y desarrollos teóricos siguieron produciéndose y en 1974 el matemático y economista Paul Werbos publicó su tesis doctoral en la que introdujo el concepto del algoritmo de retropropagación (backpropagation) que es fundamental para entrenar redes neuronales multicapa. Este algoritmo se convirtió en una base crucial para el desarrollo del aprendizaje profundo, facilitando el entrenamiento eficaz de redes neuronales y contribuyendo al avance de la inteligencia artificial.

Esquema gráfico del funcionamiento del algoritmo de retropropagación. https://www.analyticsvidhya.com/blog/2023/01/gradient-descent-vs-backpropagation-whats-the-difference/

A grandes rasgos el algoritmo de retropropagación introduce el posible error cometido en la predicción realizada por el algoritmo respecto al resultado esperado, permitiendo a la red neuronal ajustar los pesos de los cálculos que se realizan en las capas de neuronas con el objetivo de afinar cada vez mas el resultado final.

Avances como la retropropagación, el nuevo enfoque de los desarrollos que se centraban en problemas concretos, lo que resultó en lo que se dio a denominar Sistemas Expertos,Expertos, así como la fundamentación de los sistemas en la gestión estructurada de grandes cantidades de datos condujo a mediados de la década de 1980 a un resurgimiento en la investigación de la IA y a una vuelta de la financiación, impulsada no solo por iniciativa privada sino también por proyectos nacionales como en Japón o Estados Unidos.

XXXSEGUIRSin AQUIXXXembargo, a finales de la década de los 80, volvió a enfriarse el entusiasmo. Las causas en esta ocasión se encontraban en un estancamiento provocado por las limitaciones tecnológicas y la falta de robustez en los sistemas existentes. Por tanto, se dejaron de lado los proyectos en curso en lo que se denomino "segundo invierno de la IA" y los esfuerzos volvieron a centrarse en un replanteamiento del enfoque.

Este cambio de perspectiva se materializó en varios frentes:

- https://view.genial.ly/65246f2a064bf30010bfd3f4/interactive-content-montate-un-breakouteduEnfoque en Algoritmos más Eficaces:

Los investigadores comenzaron a desarrollar algoritmos más eficientes y prácticos, lo que permitió un procesamiento más rápido y resultados más precisos con los recursos computacionales disponibles en ese momento. Un ejemplo clave es el desarrollo y adopción de algoritmos de aprendizaje automático como las Redes Neuronales Artificiales (RNA).

- Tecnología de Hardware Mejorada:

Con el tiempo, la tecnología de hardware avanzó significativamente, permitiendo un procesamiento más rápido y la gestión de grandes conjuntos de datos. La llegada de procesadores más potentes y hardware especializado como las Unidades de Procesamiento Gráfico (GPU) facilitaron el avance de la IA.

- Adopción de Métodos Probabilísticos y Estadísticos:

A medidadiferencia de los enfoques lógico-deductivos previos, los nuevos enfoques comenzaron a adoptar métodos probabilísticos y estadísticos para manejar la incertidumbre y la variabilidad en los datos. Esto permitió una mayor flexibilidad y rendimiento en tareas de IA complejas.

- Desarrollo y Acceso a Grandes Conjuntos de Datos:

El acceso a grandes conjuntos de datos se volvió crucial para entrenar modelos de IA más precisos y robustos. La disponibilidad de estos datos, junto con las técnicas de aprendizaje profundo, permitió avances significativos en áreas como el procesamiento del lenguaje natural y la visión por computadora.

- Colaboración entre Academia e Industria:

Se fomentaron las colaboraciones entre la academia y la industria, lo que avanzabanresultó en una inversión significativa y en el avance de la investigación en IA. Empresas como IBM, Microsoft y Google comenzaron a invertir en laboratorios de IA, lo que contribuyó a acelerar el progreso en el campo.

- Normativas y Estándares:

Se establecieron normativas y estándares que ayudaron a guiar el desarrollo y la implementación de tecnologías de IA, facilitando así su adopción en diversos sectores.

- Interacción con el Entorno:

Los enfoques modernos de la IA buscan desarrollar sistemas que interactúen de manera efectiva con su entorno y aprendan de él. Esto es un desvío del enfoque anterior que se centraba más en la programación de reglas y lógica simbólica. Los sistemas de IA modernos, como los años,robots autónomos y los sistemas de visión por computadora, están diseñados para percibir y responder a su entorno de manera dinámica.

- Emergencia:

La emergencia se refiere a cómo las propiedades y comportamientos complejos pueden surgir de la interacción entre componentes simples y sus entornos. En la IA, esto se ve en cómo los sistemas pueden "aprender" patrones y comportamientos complejos a partir de datos e interacciones básicas con su entorno, sin que estos comportamientos estén programados explícitamente.

- "Elephants Don’t Play Chess" de Rodney Brooks:

En este artículo, Rodney Brooks argumenta en contra del enfoque tradicional basado en la lógica simbólica y a favor de un enfoque más basado en la interacción con el entorno. Brooks propone que los sistemas de IA deberían estar más arraigados en el mundo físico y ser capaces de interactuar con él de manera efectiva, en lugar de estar confinados a tareas abstractas y descontextualizadas como jugar al ajedrez. Su trabajo promovió una visión de la IA que valora la interacción con el entorno y la capacidad de adaptarse a él, lo cual es crucial para el desarrollo de GPUsrobots autónomos y otros sistemas de IA interactuantes.

En contraposición a los enfoques anteriores que se centraban en la lógica simbólica y en sistemas expertos con un conocimiento codificado de manera rígida, estos nuevos enfoques adoptaron una perspectiva más potentesflexible sey convirtióbasada en undatos, factorque clavepermitió a la IA superar el segundo invierno y entrar en una nueva era de innovación y crecimiento. Además, el impulsoapoyo continuo de la comunidad académica y de la industria, junto con avances en hardware y disponibilidad de datos, contribuyeron a superar las limitaciones que habían causado el segundo invierno de la IA.

Estos 2006,cambios seen lanzóel laenfoque GPU NVIDIA GeForce 8800 GTX, que ofrecíahacia una potenciaIA demás cómputo sin precedentes para su época, acelerando el entrenamiento de modelos de IAinteractuante y permitiendoemergente realizar cálculos paralelos masivos.

Durante este período, también se produjeron hitos notables. En 1997, el sistema de IA Deep Blue de IBM derrotó al campeón mundial de ajedrez Garry Kasparov, marcandorepresentaron un hitomovimiento significativoimportante en la capacidad de las máquinas para competir con los seres humanos en juegos complejos.

A pesarlejos de los avances,enfoques anteriores, y se alinean con la tendencia general hacia la IA experimentóque otroes inviernocapaz ende aprender y adaptarse de manera más efectiva a su entorno.

Este periodo, que abarcaría desde los primeros años de la década de 1990 debidohasta a la faltafinales de avances prácticos y el desafío de lograr la inteligencia artificial generalizada. Sin embargo, el resurgimiento de la IA en la década de 2000,2010, impulsadoestuvo porplagado de logros que supusieron hitos importantes en el aprendizaje profundo y las redes neuronales convolucionales, marcó un cambio de paradigma en la capacidad de las máquinas para el reconocimiento de patrones y el procesamiento de datos complejos.

En resumen, desde la conferencia de Dartmouth hasta 2011, la evolución de la IA estuvo marcada por avances y desafíos. El desarrollo del perceptrón y los inviernos de la IA ilustran los altibajos y las dificultades en la investigación de la IA. Sin embargo, el resurgimiento de la IA, impulsadocitamos por el desarrolloalgunos de GPUsellos:

"Attention is all you need." - Vaswani et al., "Attention Is All You Need" (2017)

"Los modelos de lenguaje como ChatGPT pueden ser herramientas increíblemente poderosas, pero también conllevan una gran responsabilidad para garantizar que se utilicen de manera ética y segura." - Sam Altman

Avances teóricos IA

Durante el periodo de 2011 a 2022, hubo un notable avance en las tecnologías de Inteligencia Artificial (IA), particularmente en el desarrollo y aplicación de redes neuronales, redes neuronales convolucionales (CNN), redes neuronales LSTM (Long Short-Term Memory), así como arquitecturas de encoders y transformers. Estas tecnologías han sido fundamentales para el procesamiento de imágenes, el procesamiento del lenguaje natural y otras tareas de IA. Aquí se presenta una visión general de su evolución:

1. Redes neuronales: Las redes neuronales han sido ampliamente utilizadas en la IA durante este periodo. Se han mejorado los algoritmos de entrenamiento, como el descenso de gradiente estocástico (SGD) y las técnicas de regularización, lo que ha permitido entrenar modelos más profundos y precisos. Además, se han desarrollado nuevas arquitecturas, como las redes neuronales residuales (ResNet) y las redes neuronales generativas adversariales (GAN), que han mejorado aún más el rendimiento y las capacidades de la IA.

2. Redes neuronales convolucionales (CNN): Las CNN han experimentado un gran avance en el procesamiento de imágenes y la visión por computadora. En 2012, el modelo AlexNet revolucionó el campo al ganar la competencia ImageNet, superando con éxito a los enfoques tradicionales. Desde entonces, se han propuesto y mejorado diversas arquitecturas de CNN, como VGGNet, InceptionNet y ResNet, que han superado los límites de precisión en tareas de clasificación, detección y segmentación de objetos en imágenes.

3. Redes neuronales LSTM (Long Short-Term Memory): Las LSTM son un tipo de red neuronal recurrente (RNN) que han sido fundamentales en el procesamiento del lenguaje natural y en la generación de texto. Las LSTM resuelven el problema de las RNN tradicionales al permitir el almacenamiento y el acceso a información a largo plazo, lo que las hace más efectivas en el procesamiento de secuencias largas. Estas redes han mejorado significativamente la capacidad de modelar y generar texto coherente y natural.

4. Arquitecturas de encoders: Las arquitecturas de encoders, como los autoencoders y las redes neuronales convolucionales encoders (CNN-Encoders), se han utilizado para la extracción de características y la representación eficiente de datos. Estas arquitecturas permiten comprimir la información relevante de una entrada en una representación latente de menor dimensión, lo que facilita el procesamiento y análisis posterior.

5. Transformers: Los transformers son una arquitectura de redes neuronales que ha revolucionado el procesamiento del lenguaje natural y otras tareas de secuencia. Introducidos en 2017, los transformers se basan en el mecanismo de atención para capturar relaciones entre elementos en una secuencia. Esta arquitectura ha demostrado un rendimiento sobresaliente en tareas como la traducción automática, la generación de texto y el procesamiento del lenguaje natural.

Es importante destacar que durante este periodo también se han producido avances en otros campos de la IA, como el aprendizaje profundo, el aprendizaje por refuerzo y la transferencia de aprendizaje. Además, la disponibilidad de conjuntos de datos masivos y

Personajes

En 2017, Goertzel fue el director científico de Hanson Robotics, la empresa que desarrolló a Sophia, uno de los robots más avanzados en términos de apariencia y capacidad de interacción social.

Durante una entrevista, se le preguntó a Sophia si podría destruir a los humanos. En ese momento, Sophia respondió de manera inesperada diciendo: "OK, lo destruiré", lo cual generó cierta inquietud y controversia. Ante esto, Goertzel intervino rápidamente para aclarar que se trataba de una broma y que Sophia no tenía la capacidad real de hacer daño a los humanos.

Esta anécdota resalta la importancia de la comunicación y el contexto en la interacción entre humanos y robots. Aunque Sophia es un avance destacado en la creación de robots sociales, también pone de manifiesto los desafíos y responsabilidades éticas asociadas con el desarrollo de la inteligencia artificial y la necesidad de establecer límites claros en cuanto a su comportamiento y capacidades.

La colaboración de Goertzel con Sophia es solo una muestra de su amplia trayectoria en la investigación de la inteligencia artificial y su compromiso con la exploración de nuevas fronteras en este campo.

Hitos IA

Del algoritmo tradicional a las redes neuronales

A partir de 2011, ha habido varios hitos importantes y avances significativos en el campo de la Inteligencia Artificial (IA). Aquí hay algunos de ellos:

2011: El sistema Watson de IBM, basado en IA, gana en el programa de televisión Jeopardy!, derrotando a dos concursantes humanos destacados. Esto marcó un hito importante en el procesamiento del lenguaje natural y la capacidad de las máquinas para comprender y responder preguntas complejas.

2012: AlexNet, un modelo de redes neuronales convolucionales desarrollado por Alex Krizhevsky, gana el desafío ImageNet Large Scale Visual Recognition Competition (ILSVRC) con un rendimiento sorprendente. Esto desencadenó el auge del aprendizaje profundo en el campo de la visión por computadora y sentó las bases para avances significativos en la detección de objetos y el reconocimiento de imágenes.

2014: Google presenta su sistema de IA llamado Google DeepMind y lanza su primer gran proyecto de IA conocido como AlphaGo. AlphaGo derrota al campeón mundial de Go, un juego extremadamente complejo y estratégico, demostrando la capacidad de la IA para superar a los mejores expertos humanos en juegos de mesa.

2016: Generative Adversarial Networks (GANs), un tipo de modelo de IA propuesto por Ian Goodfellow, permite generar contenido nuevo y realista, como imágenes y música, a través de un proceso de competencia entre dos redes neuronales. Esto revoluciona la generación de contenido y abre nuevas posibilidades en el campo de la creación artística asistida por IA.

2018: El modelo de lenguaje GPT (Generative Pre-trained Transformer) de OpenAI, desarrollado por el investigador de IA Andrej Karpathy, demuestra una capacidad asombrosa para generar texto coherente y de alta calidad. Esto destaca el poder del aprendizaje automático basado en modelos de lenguaje para la generación de texto.

2020: La IA se utiliza de manera destacada en la lucha contra la pandemia de COVID-19. Se desarrollan modelos de IA para el diagnóstico temprano, la predicción de la propagación del virus y la búsqueda de tratamientos potenciales, lo que destaca el papel crucial de la IA en la medicina y la salud pública.

Estos son solo algunos de los hitos importantes que han ocurrido en el campo de la IA a partir de 2011. La IA continúa avanzando rápidamente, con nuevos descubrimientos, aplicaciones innovadoras y desafíos éticos y sociales que surgen a medida que la tecnología evoluciona.