Unidad 3.2. Tutorial de Prompting. La impotancía de las preguntas

"Juzga a un hombre por sus preguntas y no por sus respuestas" Voltaire

"No es la respuesta la que ilumina, sino la pregunta" Eugene Ionesco

“Lo importante es no dejar de hacerse preguntas”

"Si yo tuviera una hora para resolver un problema, y mi vida dependiera de la solución, gastaría los primeros 55 minutos en determinar la pregunta apropiada, porque una vez conociera la pregunta correcta, podría resolver el problema en menos de cinco minutos"

Albert Einstein

Introducción

Ya hemos visto que la herramienta que provocó la irrupción masiva la inteligencia artificial a nivel popular fue el chatbot ChatGPT. La tecnología que hay detrás de este chat es el mencionado PLN (Procesamiento del Lenguaje Natural). A día de hoy, esta tecnología se ha utilizado para desarrollar muchos otros chatbots (Bard, Llama, Claude etc…). El PLN es un subcampo de la IA que utiliza modelos de lenguaje para predecir una secuencia de palabras.

Para poder sacar el mayor potencial de estos modelos, es crucial entender y aplicar de manera efectiva la técnica de "prompting". Esta técnica nos permite interactuar con estos modelos de lenguaje para recibir respuestas específicas y generar distintos tipos de contenido, desde texto, como en los chatbots, hasta imágenes y sonidos a través de otras herramientas que veremos más adelante.

En este capítulo, vamos a explorar el concepto de prompting de forma detallada, sus implicaciones en la IA, y su potencial aplicación en la educación.

¿Qué es el prompting? y su importancia

El prompting es una técnica utilizada para interactuar con sistemas de IA mediante indicaciones o preguntas específicas . Es el medio por el cual se le pide a un modelo de lenguaje o a un algoritmo de IA que realice una acción o que genere una respuesta. Este concepto es fundamental para aprovechar plenamente las capacidades de los modelos de IA, especialmente en el procesamiento de lenguaje natural (PLN).

El prompting nos lleva a introducir al modelo un prompt, lo que en castellano podríamos traducir como “cuestión, pregunta o Indicación”.

Por tanto, el prompting se trata, dicho de manera simple, de pensar y trabajar la indicación o pregunta que vamos a realizarle al modelo de IA para que la respuesta o resultado que el modelo nos presente sea lo más ajustado posible a nuestra solicitud y nos aporte un contenido lo más valioso posible.

Un ejemplo aclaratorio:

Todos hemos hecho búsquedas en cualquiera de los buscadores disponibles por internet. Al hacerlas, en mayor o menor medida hacemos un esfuerzo para introducir el texto adecuado para que el motor de búsqueda encuentre la web o webs más relevantes para nuestra necesidad concreta. Ese esfuerzo que hacemos para que nuestra entrada facilite al buscador ofrecernos lo que buscamos sería el prompting. En el contexto de un motor de búsqueda, esto se traduciría en cómo eliges y organizas las palabras clave para obtener los resultados más relevantes. Es una especie de "arte" en cómo haces la pregunta para obtener la mejor respuesta

A su vez, el texto que introducimos en el buscador representaría el prompt. Es la consulta específica que generas, compuesta de palabras clave, frases o preguntas, que el motor de búsqueda procesa para obtener resultados.

El prompting es esencial para una gran variedad de aplicaciones de IA. Desde asistentes virtuales hasta motores de búsqueda y sistemas de recomendación, el diseño y la implementación efectiva de prompts son cruciales para la eficacia y precisión de estos sistemas. Además, con la aparición de modelos más avanzados y diversos, el papel del prompting se ha expandido para incluir la generación de contenido más allá del texto, como imágenes y sonidos.

Imagen propia. Generada por el Generador de imágenes de Bing.

Imagen propia. Generada por el Generador de imágenes de Bing.

Evolución del prompting

En los albores de la computación, las interacciones con las máquinas eran bastante rudimentarias. Las interfaces de línea de comandos fueron algunas de las primeras formas de prompting, donde los usuarios ingresaban comandos de texto específicos para obtener respuestas o realizar tareas.

Con el tiempo y el avance tecnológico, las formas de interactuar con las máquinas se han vuelto cada vez más sofisticadas. Pasamos de las interfaces de línea de comandos (MS-DOS) a interfaces gráficas de usuario (Windows) y luego a interacciones más intuitivas gracias a la IA. Los modelos de lenguaje de gran escala como por ejemplo GPT-3 (modelo detrás de ChatGPT) y LaMDA (modelo detrás de Bard) permiten ahora una interacción mucho más natural y conversacional. A través de prompts bien diseñados, estos y otros modelos pueden comprender y generar texto, imágenes, y sonidos que son increíblemente cercanos a lo que un humano podría producir o entender.

En sus inicios, el prompting se limitaba principalmente al texto. Sin embargo, con el desarrollo de modelos de IA más avanzados, ahora es posible generar y analizar diferentes tipos de medios. Por ejemplo, existen modelos que pueden generar imágenes basadas en descripciones de texto (prompts de imagen), y también modelos que podrían generar un texto basándose en una imagen (que en este caso haría el papel de prompt), pero también modelos que pueden componer música basada en ciertas instrucciones o emociones (prompts de audio). Esta evolución ha ampliado enormemente el alcance y las aplicaciones del prompting, permitiendo una gama más amplia de interacciones y generación de contenido.

Modelos capaces de entender prompts de diferentes tipos y generar resultados también de diferentes tipos serían los mencionados multimodales. Un ejemplo: introducir una imagen de un paisaje otoñal en un modelo de este tipo, y solicitar que genere un poema que capture la esencia de la imagen.

Este tipo de interacción representa una evolución emocionante en el campo del prompting, ya que amplía significativamente las formas en que podemos interactuar con los modelos de IA. Los prompts ya no están limitados al texto, sino que pueden abarcar una variedad de medios, incluidas imágenes, sonidos y quizás más en el futuro.

Esta funcionalidad tiene aplicaciones potenciales muy interesantes, no solo en el ámbito del arte y la creatividad, sino también en campos como la educación, donde podría emplearse para enseñar conceptos como la interpretación de imágenes, la escritura creativa o incluso la empatía y el entendimiento cultural.

Tipos de prompts

Como acabamos de ver, a medida que la inteligencia artificial ha evolucionado, los prompts que podemos utilizar para interactuar con los modelos también lo han hecho. Mientras que en sus inicios el prompting se centraba exclusivamente en el texto, la tecnología actual permite una gama mucho más amplia de interacciones.

El desarrollo de la IA le permite abordar una amplia variedad de modalidades. Las "modalidades" en este contexto se refieren a las diferentes formas de datos o información que los sistemas de IA pueden procesar (prompt de entrada) o generar (salida de la IA).

En la siguiente tabla vamos a resumir todas las modalidades que la IA generativa nos ofrece. Cada una de las cuales admite uno o más tipos de prompts.

|

Prompt (entrada) |

Respuesta IA (salida) |

Ejemplo de uso |

|

Texto |

Texto |

Chatbot, traducción, resumen… |

|

Texto |

Imagen |

Generación imagen desde texto |

|

Texto |

Video |

Generación de video desde texto |

|

Texto |

Audio |

Síntesis de voz, sistemas Text-To-Speech, generación de música |

|

Imagen |

Texto |

Descripción imagen, reconocimiento óptico de caracteres (OCR) |

|

Imagen |

Imagen |

Colorización de imágenes en blanco y negro, superresolución, estilo transfer entre imágenes |

|

Audio |

Texto |

Transcripción automática, reconocimiento de voz |

|

Audio |

Audio |

Eliminación de ruido, cambio de tono o velocidad |

|

Video |

Texto |

Subtitulación, descripción automática del contenido |

|

Video |

Video |

Mejora de resolución de video, transferencia de estilos de videos |

|

Combinación de anteriores |

Cualquiera o una combinación de las anteriores |

MULTIMODALIDAD: Sistemas que pueden recibir una imagen y una pregunta en texto sobre esa imagen, y proporcionar una respuesta en texto o audio. |

Estas son algunas de las principales modalidades en las que operan los sistemas de IA. Pero hay que subrayar que la investigación en IA está en constante evolución, y con el tiempo es probable que veamos aún más capacidades y combinaciones en términos de modalidades.

A continuación, examinaremos con mayor profundidad algunas posibilidades de los tipos de prompts de uso mas común

Prompts de Texto

El texto ha sido tradicionalmente el medio más común para el prompting en IA. Los prompts de texto se introducen generalmente en forma de preguntas o indicaciones. Dentro de los prompts de texto podemos distinguir en base al tipo de respuesta que queremos obtener:

- Prompts abiertos vs cerrados:

Los prompts abiertos son aquellos que no limitan las respuestas de la IA, como "Háblame sobre el cambio climático".

Los prompts cerrados, en cambio, buscan respuestas específicas, como "¿En qué año nació Albert Einstein?".

- Prompts de selección múltiple. A veces, se presenta a la IA una serie de opciones y se le pide que elija la correcta o la más adecuada según el contexto. Por ejemplo: "¿Cuál es la capital de Francia? A) Madrid, B) Berlín, C) París".

- Prompts de texto libre. Son aquellos en los que se le da libertad a la IA para generar contenido, como "Escribe un cuento corto sobre un robot".

Prompts Visuales

Con la evolución de los modelos de IA hacia capacidades multimodales, es posible usar imágenes o videos como prompts. Con estos prompts se le puede solicitar a la IA que describa la imagen, identifique objetos en ella o, como se mencionó anteriormente, genere texto creativo inspirado en la imagen. También puede pedírsele una salida de la imagen o video mejorada o modificada.

Prompts de Audio

La capacidad de procesar y generar audio ha abierto una nueva dimensión en el mundo del prompting. Los prompts de audio pueden variar desde simples indicaciones verbales hasta la introducción de fragmentos de música o sonidos específicos.

- Sonidos. Se pueden usar para que la IA identifique o describa, como el canto de un pájaro o el ruido de la lluvia.

- Música. Puede servir como inspiración para que la IA genere letras de canciones, identifique el género musical o incluso cree una melodía complementaria.

Estos son solo ejemplos de las posibilidades ya explotadas y de uso frecuente. La versatilidad y el potencial de la inteligencia artificial moderna abre un mar de posibilidades. Ya no estamos limitados a interacciones basadas en texto; la IA ahora tiene la capacidad de comprender y generar contenido en una variedad de medios, lo que permite aplicaciones mucho más ricas y diversificadas en numerosos campos.

Cómo funciona el prompting en IA

El prompting en la inteligencia artificial, desde el punto de vista del usuario, se resume en proporcionar una entrada más o menos elaborada y esperar una respuesta, si bien este proceso, muchas de las veces, requerirá de un cierto número de iteraciones hasta que la IA nos genere la respuesta conveniente.

Detrás de cada respuesta generada por un modelo de IA, hay una serie de procesos y tecnologías complejas. Vamos a realizar una ligera introducción que nos permita entender conceptualmente cómo funcionan estos sistemas, centrandonos en el Procesamiento del Lenguaje Natural (PLN) dado que es el que, en principio, más nos puede interesar como docentes. Si bien, veremos que conceptualmente el funcionamiento interno de los modelos tiene muchas similitudes independientemente de que se trate de un modo u otro.

El prompting en el Procesamiento de Lenguaje Natural (PLN)

Hemos visto que una parte de la IA se centra en los modelos Text2Text. Estos modelos requieren la introducción de un texto y devuelven otro texto como respuesta, ya sea una respuesta concreta, una conversación con un Chatbot, un resumen, una traducción…

La tecnología que hay debajo de esta modalidad es el Procesamiento de Lenguaje Natural (PLN)

El PLN, como sabemos, es una rama de la inteligencia artificial que se centra en la interacción entre las computadoras y el lenguaje humano. Su objetivo es permitir que las máquinas entiendan, interpreten y generen lenguaje de manera que sea valioso para los usuarios humanos.

El prompt es la entrada que la computadora debe entender, interpretar y utilizar para elaborar una respuesta útil. Al proporcionar un prompt textual, el modelo de lA procederá primero a su análisis. El análisis del prompt puede dividirse en los siguientes pasos:

- Identificación de las palabras clave: El sistema identifica las palabras clave en el prompt. Estas palabras clave son importantes para comprender su significado.

- Análisis de la estructura gramatical: El sistema analiza la estructura gramatical del prompt, lo que ayuda al sistema a comprender la relación entre las palabras y frases introducidas por el usuario.

- Identificación del contexto: El sistema identifica el contexto del prompt. Esto ayuda al sistema a comprender mejor su significado dentro del contexto de la conversación o tarea en la que se está utilizando.

Una vez que el sistema ha completado el análisis, puede comprender el significado y propósito del prompt, y le permite generar una respuesta adecuada.

Veamos un ejemplo sencillo:

Prompt: ¿Cuál es la capital de España?

- Identificación de las palabras clave: Si el prompt es "¿Cuál es la capital de España?", las palabras clave serían "capital" y "España".

- Análisis de la estructura gramatical: Si el prompt es "¿Cuál es la capital de España?", la estructura gramatical es una pregunta.

- Identificación del contexto: Si el prompt es "¿Cuál es la capital de España?", el contexto es una conversación sobre geografía.

Obviamente la respuesta que da el sistema es: Madrid

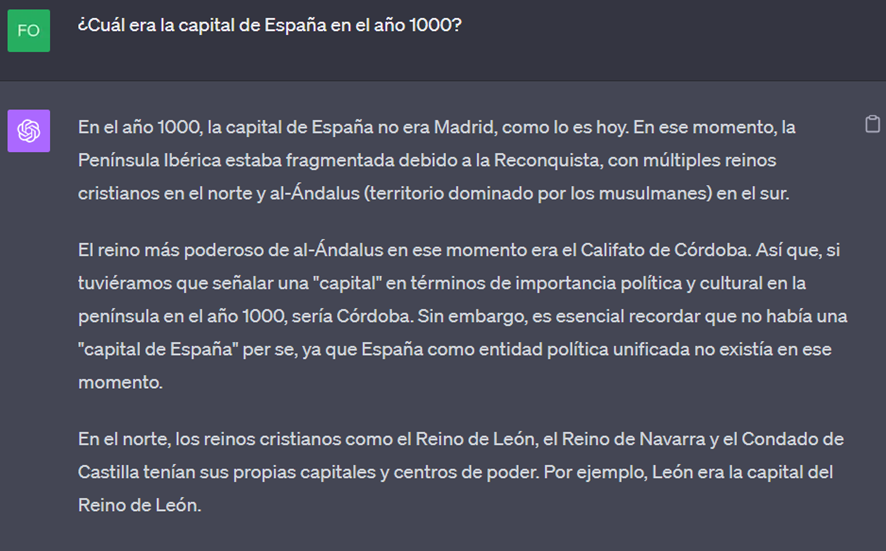

Sin embargo, cambiando un poco el contexto, el chatbot Chat GPT nos contesta

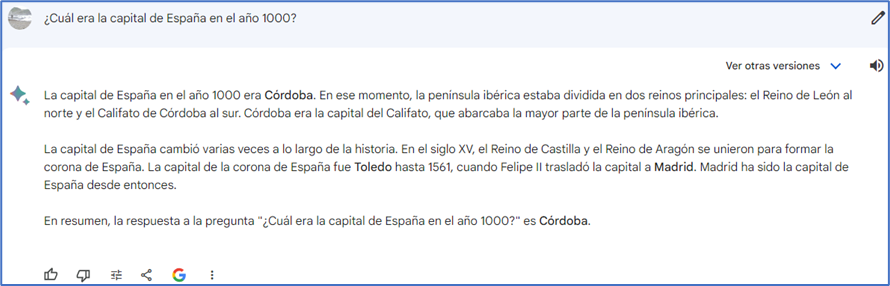

Y si le preguntamos lo mismo a Bard (Chatbot de Google):

Las respuestas son similares pero no idénticas. El corpus de documentación con la que se les ha entrenado será muy similar (básicamente todo el conocimiento humano "verificado" que pueda estar presente en internet hasta cierto momento) pero el proceso de entrenamiento y los algoritmos que procesan el prompt y generan la respuesta puede ser diferente.

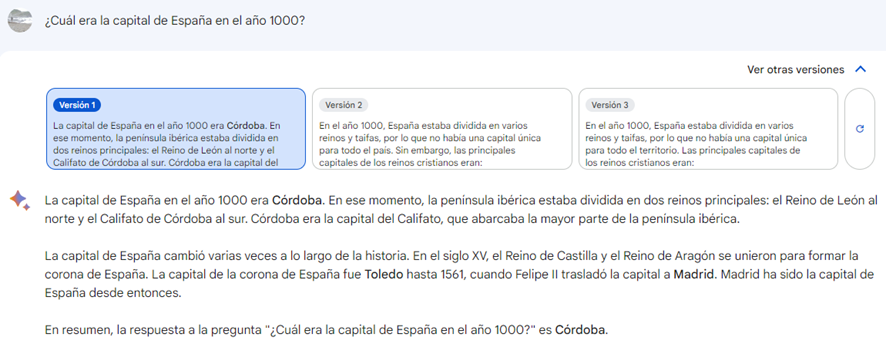

Si bien ChatGPT ofrece una única respuesta inicial que puede ser modificada si se matiza el prompt, Bard presenta una respuesta principal y ofrece la posibilidad de, sin hacer matizaciones al prompt inicial, escoger entre 3 posibles respuestas:

Este ejemplo nos sirve para entender que distintos chatbots pueden generar distintas respuestas ante un mismo prompt y que es preciso realizar verificaciones de las mismas y no darlas por buenas sin mas.

Para entender más a fondo el funcionamiento interno de la IA, cómo esta es capaz de interpretar el prompt y dar una respuesta adecuada, profundizamos un poco y analizamos con mayor detalle los sencillos pasos descritos previamente. Introducimos además algo de lenguaje técnico muy presente en el ámbito de la IA, por lo que conviene familiarizarse con él (algunos de los conceptos y mecanismos ya se estudiaron en el módulo 2)

- Tokenización. El modelo comienza por dividir el prompt en tokens, que son fragmentos más pequeños del texto, como palabras o subpalabras (conjuntos de letras dentro de una palabra, prefijos, sufijos...).

- Embedding del texto. Cada token se convierte en un vector numérico, conocido como embedding. Estos embeddings se obtienen de grandes matrices preentrenadas que representan palabras o subpalabras en un espacio vectorial, donde palabras semánticamente similares están cercanas entre sí. Así cada embedding es una representación numérica de cada token que captura su semántica y significado. Dicha representación se basa en la cercanía semántica del contenido con respecto a la vasta información con la que el modelo ha sido entrenado.

- Procesamiento Interno.

- Codificador: El modelo procesa estos embeddings para entender el contexto y la relación entre los tokens. Esto se hace a través de múltiples capas de la red neuronal y mecanismos como la atención, que le permite al modelo darle un mayor peso o importancia a ciertos tokens en función de su relevancia en el contexto. Tras este procesamiento el modelo transforma los emmbedings (recuerda que es el prompt textual en forma de vector) en un conjunto compacto de características. Es decir, se reduce la dimensionalidad del vector original convirtiéndolo en algo más compacto pero que incluye todas sus características. Podríamos decir que capta la esencia del prompt.

- Decodificador: Usando la información contextual obtenida, el modelo genera una respuesta token por token, basándose en probabilidades y contextos aprendidos durante el entrenamiento.

-

- Ejemplo de este proceso. Mecanismo de estudio: Normalmente los textos no se aprenden de manera literal sino que, para estudiarlos, se procede a entender el contexto de un hecho concreto y únicamente se memorizan los conceptos mas relevantes en relación con ese hecho. Este sería nuestro entrenamiento previo del "modelo de estudio". Si después nos preguntan por lo estudiado (lo que equivaldría al prompt), nuestro cerebro va a analizar la pregunta extrayendo de la misma aquellas palabras más relevantes en relación al contexto de la pregunta para poder construir la respuesta posterior (estaría codificando el prompt, reduciendo sus dimensiones, agrupando toda la información relevante de la pregunta para convertirlo en algo compacto con significado propio). Por ultimo, nuestro cerebro comienza a construir una respuesta coherente en base a los conceptos y contexto relevante de la pregunta y cuyo contenido esta relacionado con la misma y se nutre de lo estudiado. En términos de IA, el contenido de la pregunta, compactado en un emmbeding, tiene un significado cercano en la nube de palabras y conceptos de entrenamiento.

- Generación Iterativa: La respuesta textual se genera de manera iterativa, considerando no solo el prompt inicial, sino también las palabras o tokens previamente generados para asegurar coherencia.

- Resultado Final: El modelo produce una secuencia de texto que sirve como respuesta o continuación del prompt.

El prompting en otros modelos de generación

Los modelos de texto a imagen o audio transforman descripciones textuales en representaciones visuales o de audio. El proceso interno coincide en la parte de comprensión del prompt con el detallado en el apartado anterior si bien difiere en la generación ya que en este caso se trata de una imagen o sonido en lugar de un texto. El proceso sería conceptualmente muy similar al descrito si bien existen algunas especificidades. Vamos a introducir los matices necesarios para adaptar la descripción realizada para el proceso prompting para la generación de texto al proceso para generar imágenes.

- Tokenización. Al igual que con el texto, las imágenes también pueden ser divididas en tokens, aunque de una manera diferente. Aquí, los tokens pueden representar ciertos segmentos o características de la imagen. Estos segmentos no son necesariamente "sub-imágenes", sino más bien patrones visuales o características identificables.

- Embedding del texto. Al igual que con el texto, cada token de imagen se convierte en un vector numérico. Sin embargo, estos embeddings capturan características visuales en lugar de semánticas.

- Proceso interno. Al generar una imagen, el modelo no produce una palabra o token a la vez, sino que puede generar o refinar zonas de la imagen de manera iterativa hasta que se complete la imagen deseada.

- Ejemplo. Imagina que estás pintando un paisaje. En lugar de memorizar y reproducir cada detalle exactamente, recuerdas los conceptos principales (montañas, cielo, árboles) y los pintas basándote en esa memoria y la interpretación del prompt (por ejemplo, "paisaje al atardecer").

Tanto para imagen como para otros casos, como el audio, los pasos son muy similares a lo descrito para el texto, con la principal diferencia de que el tipo de contenido que se está procesando y generando es distinto.

Es importante mencionar que la calidad y la precisión del texto, imagen o audio generado dependen en gran medida del modelo específico, de la cantidad y calidad de los datos con los que fue entrenado, y de la claridad y especificidad del prompt textual proporcionado. Este último aspecto es el que desarrollaremos a continuación.

Importancia en el diseño de prompts

En la interacción con modelos de inteligencia artificial generativos, el diseño de los prompts juega un papel crucial. Determinan no solo la calidad de la respuesta del modelo, sino también su utilidad, precisión y seguridad. Vamos a explorar algunos aspectos clave relacionados con el diseño de prompts.

Claridad y ambigüedad en la redacción de prompts

- Importancia de la claridad. Un prompt claro orienta al modelo de IA hacia una respuesta específica y relevante. Los modelos generativos dependen en gran medida de la precisión del input proporcionado. Por ejemplo, preguntar "¿Cuál es la capital de Francia?" es directo y produce una respuesta clara, mientras que "Dime algo sobre Europa" es ambiguo y puede resultar en una variedad de respuestas.

- Riesgos de la Ambigüedad. Los prompts ambiguos pueden llevar a respuestas imprecisas o incluso incorrectas. Además, en aplicaciones críticas como atención médica o decisiones financieras, la ambigüedad puede tener consecuencias graves.

Prompts pre-entrenados vs customizados

- Prompts pre-entrenados. Son aquellos que ya han sido probados y optimizados durante el entrenamiento del modelo. Estos prompts son generalmente efectivos para tareas comunes y ofrecen respuestas consistentes. La naturaleza "pre-entrenada" no significa que estén codificados o predeterminados en el modelo. Más bien, se han probado y se sabe que producen buenos resultados debido a la amplia cobertura de esos temas en los datos de entrenamiento.

- Prompts customizados. Permiten a los usuarios adaptar el modelo a necesidades específicas o contextos particulares. Aunque ofrecen flexibilidad, requieren una comprensión más profunda del modelo y a menudo implican un proceso iterativo de prueba y error para afinar el resultado final.

Equilibrio entre ambos: Es recomendable comenzar con prompts pre-entrenados y luego personalizarlos según las necesidades, aprovechando lo mejor de ambos mundos.

- Ilustremos esta recomendación con un ejemplo sencillo:

Contexto: Imagina que eres un profesor de historia que desea usar un modelo de lenguaje para ayudar a sus estudiantes a comprender mejor los eventos históricos. Quieres que el modelo describa la Revolución Francesa en un lenguaje sencillo y fácil de entender.

Podríamos usar un prompt pre-entrenado como: "Describa la Revolución Francesa."

La respuesta que obtendrías podría ser amplia y general, ofreciendo un resumen sobre la Revolución Francesa, sus causas, eventos clave y consecuencias.

Pero podremos ajustar mas la respuesta del modelo a nuestra necesidad si utilizamos un prompt personalizado (Customizado) basado en el Pre-entrenado como:

"Describa la Revolución Francesa en un lenguaje simple y adecuado para estudiantes de secundaria, mencionando sus causas principales, eventos clave y figuras importantes y con una extensión aproximada de XX palabras."

Este prompt customizado toma la base del prompt pre-entrenado (la descripción de la Revolución Francesa) pero añade especificaciones para adaptar la respuesta a las necesidades del profesor: un lenguaje sencillo, la extensión y ciertos puntos clave que deben ser mencionados.

Como resultado, al usar el prompt personalizado, el profesor puede esperar obtener una descripción adaptada al nivel educativo de sus estudiantes, centrándose en los puntos más relevantes para su plan de estudio. Al mismo tiempo, al partir de una base pre-entrenada, garantiza que el tema central sea tratado con precisión.

En este ejemplo, el profesor combina la claridad y efectividad de un prompt pre-entrenado con las adaptaciones específicas de un prompt customizado, obteniendo una respuesta que se adapta perfectamente a sus necesidades educativas.

Aspectos clave en el diseño de prompts

Desde un punto de vista practico debemos tener en cuenta ciertas pautas a la hora de diseñar un prompt, algunas de la claves son:

- Claridad y especificidad. Es fundamental ser explícito sobre lo que se espera del modelo. Una instrucción clara y detallada reduce la ambigüedad y guía al modelo hacia la respuesta deseada. Por ejemplo, en lugar de escribir "resumir esto", se podría escribir "resumir este artículo de 5 páginas sobre la historia del arte renacentista".

- Contextualización. Proporcionar contexto ayuda al modelo a entender mejor la tarea y a generar respuestas adecuadas. Si estás preguntando sobre un tema que sigue a una discusión anterior, recapitula o refiere a esa información previa.

- Limitación de la respuesta. En ocasiones, es útil establecer límites para la respuesta. Si solo necesitas una respuesta breve o en un formato específico (por ejemplo, una lista o una tabla), indica eso en tu prompt.

- Iteración y refinamiento. No todos los prompts darán el resultado deseado en el primer intento. Evaluar las respuestas, identificar áreas de mejora y ajustar la instrucción puede ser esencial para obtener una respuesta óptima.

- Evitar sesgos y suposiciones. Es importante recordar que los modelos reflejan el conocimiento y los sesgos presentes en los datos con los que fueron entrenados. Evita formular preguntas que incluyan suposiciones innecesarias o sesgadas. En su lugar, esfuérzate por ser neutral y objetivo.

Por muy bien diseñado que esté un prompt, no debemos olvidar que los modelos del lenguaje pueden alucinar. Las alucinaciones son una preocupación común cuando se trata de modelos de lenguaje grande como ChatGPT. Estos modelos pueden generar respuestas que parecen plausibles pero que son completamente falsas. Es importante recordar que estos modelos no tiene una comprensión real del mundo y pueden generar información incorrecta. Por lo tanto, siempre es esencial verificar cualquier afirmación que haga el modelo.

Consideraciones éticas en el diseño de prompts

En relación con algunos de los aspectos mencionados anteriormente como las alucinaciones o los sesgos, debemos tener muy en cuenta las consideraciones éticas en el diseño de prompts. Esto es un anticipo de lo que veremos en el módulo 5, con una unidad dedicada a las consideraciones éticas de la IA.

Sesgos y prejuicios. Es fundamental ser consciente de los sesgos inherentes en los modelos de IA, que provienen de los datos con los que fueron entrenados. Diseñar prompts sin considerar estos sesgos puede perpetuar o amplificar prejuicios existentes.

Privacidad. Al diseñar prompts, especialmente en aplicaciones educativas o médicas, es vital garantizar que no se solicite ni se revele información personal o sensible.

Claridad en las intenciones. Debe evitarse el diseño de prompts que busquen respuestas engañosas, manipuladoras o con fines malintencionados. Es esencial que los desarrolladores y usuarios tengan responsabilidad en la interacción ética con los modelos.

Educación y formación. Para quienes diseñan y utilizan prompts, es fundamental recibir formación en ética y responsabilidad. Con la creciente dependencia de la IA en muchos ámbitos, se debe garantizar que se utilice de manera beneficiosa y justa.

El diseño de prompts, por lo tanto, no es simplemente una cuestión técnica. Implica consideraciones de claridad, adaptabilidad y ética. Un diseño de prompt bien pensado puede maximizar la eficacia de la IA, mientras que un diseño deficiente o irresponsable puede llevar a resultados no deseados o incluso perjudiciales.

Uso y ejemplos de prompting en educación

Vamos a ver a continuación algunos ejemplos de aplicación del prompting con propósitos educativos (válidos para profesores, alumnos y en general cualquiera que esté interesado en enseñar o aprender sobre un tema específico). Lo haremos a modo ilustrativo trabajando con ChatGPT, pero el proceso de diseño e iteración es similar para cualquier chatbot y muy semejante en cualquier herramienta de IA generativa.

Imagen propia. Generada por el Generador de imágenes de Bing

Imagen propia. Generada por el Generador de imágenes de Bing

Tenemos claro que unas instrucciones precisas, son la clave para obtener las respuestas adecuadas. También que en ocasiones será necesario iterar varias veces hasta dar con la indicación que nos dé la mejor salida. Pero una vez encontrada la indicación (prompt) que funciona, podemos usarla tantas veces como necesitemos, esperando recibir en todas las ocasiones, una respuesta similar y adecuada.

Una recomendación importante, independientemente del chatbot utilizado (ChatGPT, Bard, Claude, Bing…) es que cada vez que iniciemos un chat para trabajar un nuevo tema, nos mantengamos dentro del mismo en la medida de los posible. De esta manera, el contexto de la conversación será de ayuda para que el chatbot entienda mejor tus indicaciones. Igualmente, si cambias de tema, abre un nuevo chat.

Se ha de tener en cuenta a su vez, la longitud del prompt que introduzcamos. Dependiendo del chatbot utilizado y de la evolución de la conversación, variará la longitud máxima recomendada a partir de la cual la respuesta puede no ser tan precisa como se esperaría. Esta longitud puede variar entre 500 y 2000 palabras dependiendo de los casos.

Comenzaremos con ejemplo de prompts básicos e iremos añadiendo complejidad sucesivamente.

Para facilitar la comprensión de temas que resulten difíciles de comprender, obtener las ideas clave sobre un tema, recibir consejos de estudio, evaluar sobre la evolución en el aprendizaje y en general empezar a aprender sobre un tema nuevo podemos introducir los siguientes prompts:

¿Puedes explicar [tema] de manera simple?

¿Cuáles son los aspectos más importantes sobre [tema]?

¿Puedes hacerme una prueba para evaluar lo que he aprendido sobre [tema]?

¿Dime algún consejo para estudiar y memorizar información relacionada con [tema]?

Resume el texto siguiente en forma de lista con los puntos más importantes. Texto: [pegar texto]

Resume el libro en forma de lista con los puntos más importantes. libro: [título del libro]

Resume el texto siguiente en forma de lista con los puntos más importantes de la página web: [insertar URL]

El tema, texto, título del libro, URL, etc... al que nos estemos refiriendo, No hay que introducirlo entre corchetes

Algunos chatbots no son capaces de navegar (ChatGPT versión gratuita no es capaz de hacerlo a fia de hoy). Por lo que para referirnos a una URL deberemos utilizar otros chatbots como; Bard, Bing, o ChatGPT Plus, entre otros

Si la información a la que nos referimos esta en otro idioma, se le puede pedir que lo traduzca:

Traduce este texto a [idioma]: [insertar texto]

Otros ejemplos de prompts que permiten obtener resultados adecuados para acelerar el proceso de aprendizaje serían aquellos que nos permitan; crear mapas mentales es una de las posibilidades, crear analogías, solicitarle que actué como un personaje histórico o una personalidad relevante en una determinada materia y simular una conversación con ella, generar planes de estudio, crear tablas para organizar información, idear actividades de evaluación (test, cuestionarios, etc...).

Vemos ejemplos de cada caso:

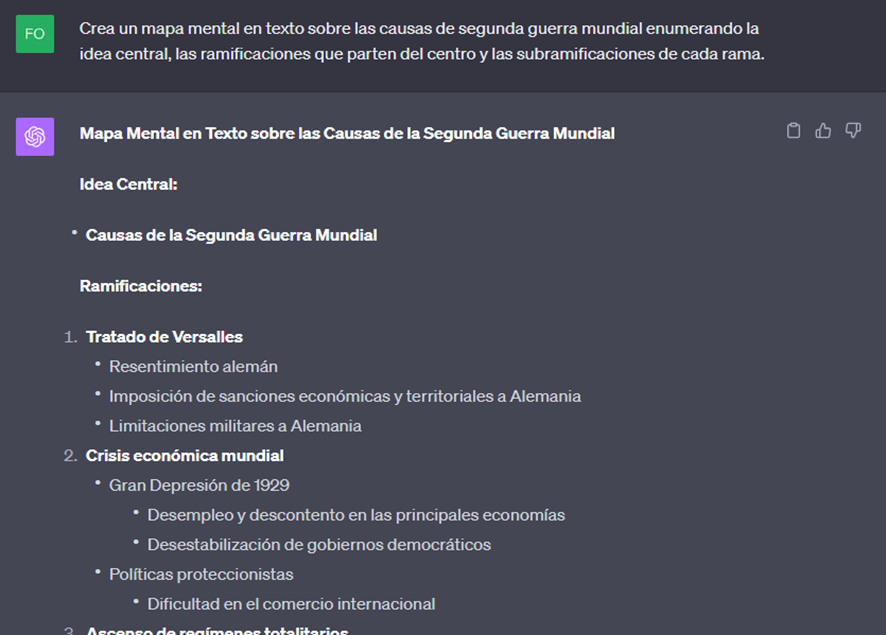

Creación de mapas mentales (ejemplo: historia)

Prompt: Crea un mapa mental en texto sobre [tema] enumerando la idea central, las ramificaciones que parten del centro y las subramificaciones de cada rama.

Como ya se ha indicado, la posibilidad de ampliar, reducir o modificar cualquier parte de la respuesta existe y solo hay que indicarle al chat lo que necesitemos.

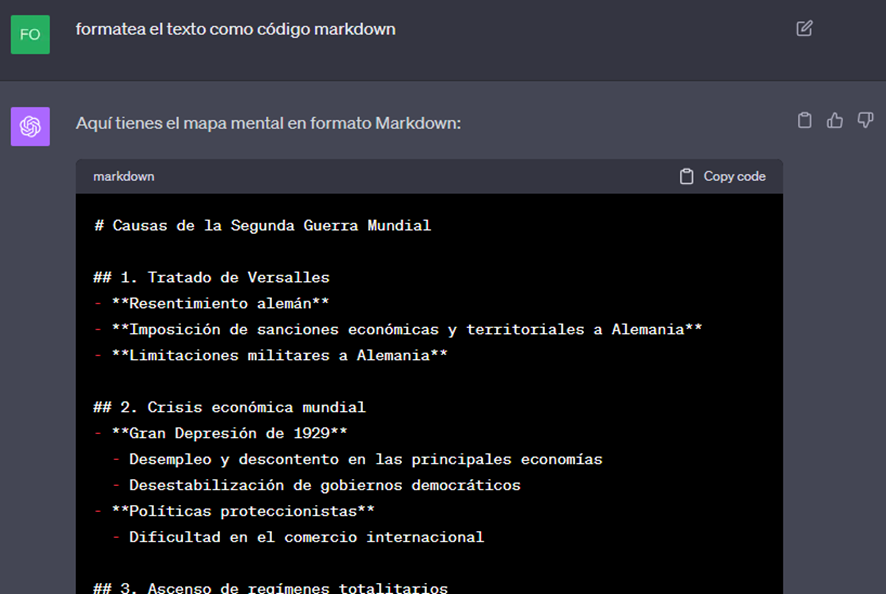

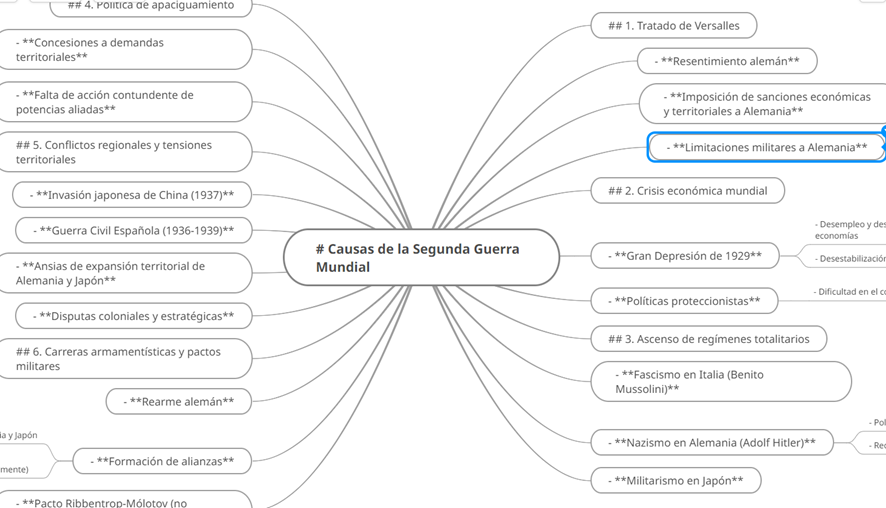

Si queremos ver el mapa mental gráficamente le podemos pedir que lo formatee como código «Markdown» o en el formato que la aplicación con la que queramos generar el mapa mental gráfico necesite, de manera que podrás crear un archivo.txt e importar el mapa mental en herramientas como Mindomo o Xmind, que generarán automáticamente el gráfico del mapa mental.

(con la opción de plugins que veremos en el módulo 4, la versión ChatGPT Plus pude realizar el gráfico sin necesidad de los pasos que aqui vamos a realizar)

Prompt: Formatea el texto como código [nombre]

Ver el ejemplo completo en el siguiente link: https://chat.openai.com/share/9488f559-cbd3-436f-924a-77b729bb907c

Para importar este código en Mindomo, pulsa en Copy Code (arriba a la derecha de Chat GPT), pega el texto en TextEdit (MAC) o Bloc de Notas (Windows) y guarda el archivo. Ahora simplemente importa este archivo .txt dentro de Mindomo y verás tu mapa mental creado en segundos.

https://www.mindomo.com/mindmap/d8428ef1c3d54af98a34da10f865cc34

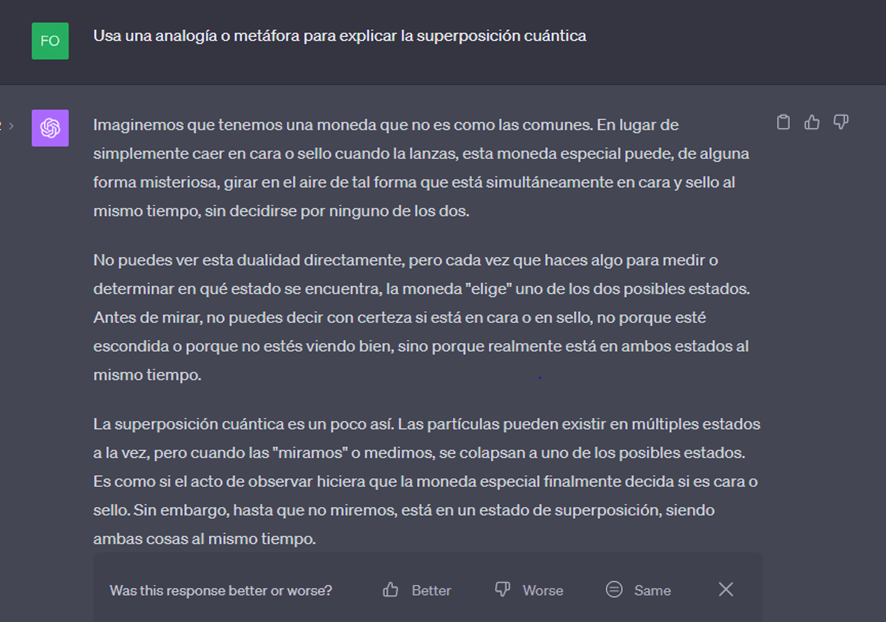

Crear analogías (ejemplo: física)

Un recurso muy útil para asimilar conceptos es crear analogías que permita entender mediante un símil conceptos complejos. Algo en lo que los chatbots basados en los modelos de lenguaje, como ChatGPT son muy capaces.

Prompt: Usa una analogía o metáfora para explicar [tema]

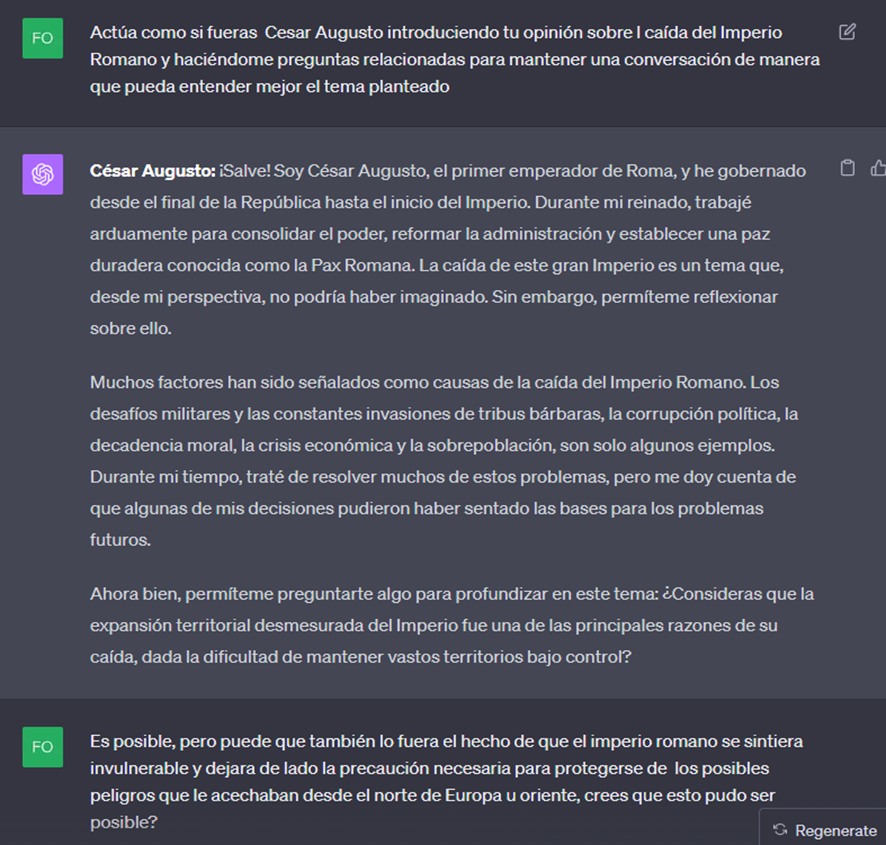

Simular personaje históricoo rol (ejemplos: historia, lengua)

También es un recurso muy interesante pedir a ChatGPT que actúe como un personaje histórico o una personalidad relevante en una determinada materia y simular una conversación con ella.

Prompt: Actúa como si fueras [personaje relevante] introduciendo tu opinión sobre [tema concreto] y haciéndome preguntas relacionadas para mantener una conversación de manera que pueda entender mejor el tema planteado

Aquí un ejemplo de en el que se le pide que actué como Julio Cesar en el que se genera una conversación sobre la caída del imperio romano.

Conversación completa y opción de continuarla: https://chat.openai.com/share/36c5352a-15a5-4984-915f-4368a716ae22

Esta opción puede resultar muy atractiva en el aula, estableciendo por ejemplo una entrevista entre los estudiantes y el personaje elegido.

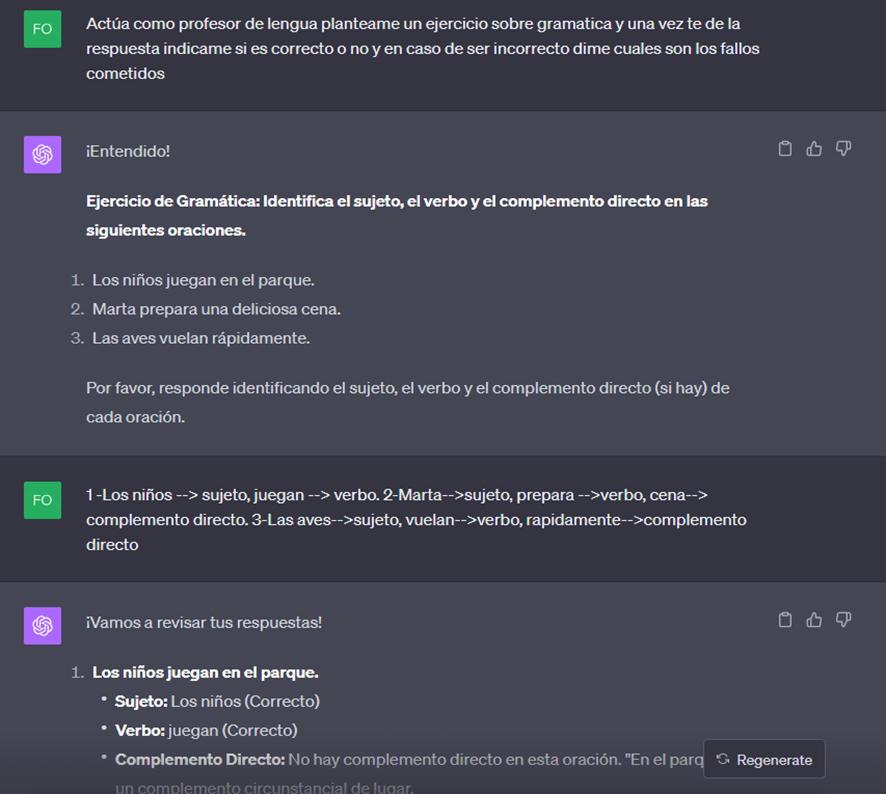

Del mismo modo, en lugar de un personaje histórico puede pedírsele al chatbot que actué como un profesor de una materia y nivel educativo concreto nos plantee ejercicios o problemas de la materia, corrigiendo la respuesta en caso de nos ser correcta o sugiriendo puntos de mejora.

Prompt: Actúa como profesor de [materia y nivel educativo] Plantéame un ejercicio sobre [tema concreto] y una vez te de la respuesta indícame si es correcto o no y en caso de ser incorrecto dime cuales son los fallos cometidos

Conversación completa: https://chat.openai.com/share/9178e64b-960c-4a72-b676-8213ce5496f8

Revisa el enlace y observa que la corrección final del chatbot no es algo confusa, en este caso, habrá que iterar hasta pulir la respuesta a quella que se ajuste perfectamente a lo que creemos adecuado. Es es la manera de conseguir "comprender" la manera que tiene el chatbot de entender nuestrasnestras preguntas. Consiguiendo esto, seremos capaces de diseñar mejores prompts y de conservar aquellos que nos resultenresuluten útiles para futuras ocasiones.

En cualquier caso, este caso es un ejemplo ilustrativo de la necesidad de mantener cierto escepticismo ante las respuestas y de una supervisión humana al proceso.

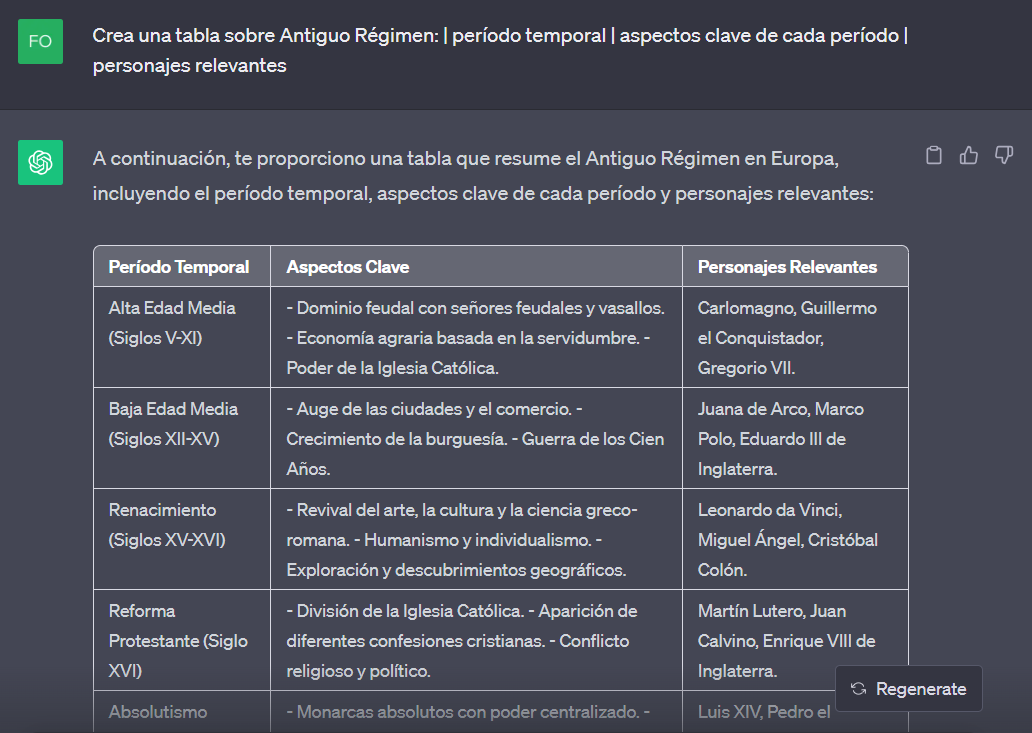

Creación de tablas (ejemplos: historia, lengua)

Podemos crear tablas para organizar información de cualquier tema, pudiendo especificar los conceptos y orden de cada columna a través de una separación con una barra vertical.

Prompt: Crea una tabla sobre [tema]: Concepto 1 | Concepto 2 | Concepto 3

Respuesta completa: https://chat.openai.com/share/4276f3e0-fc25-41c3-94a1-89f29abecb1b

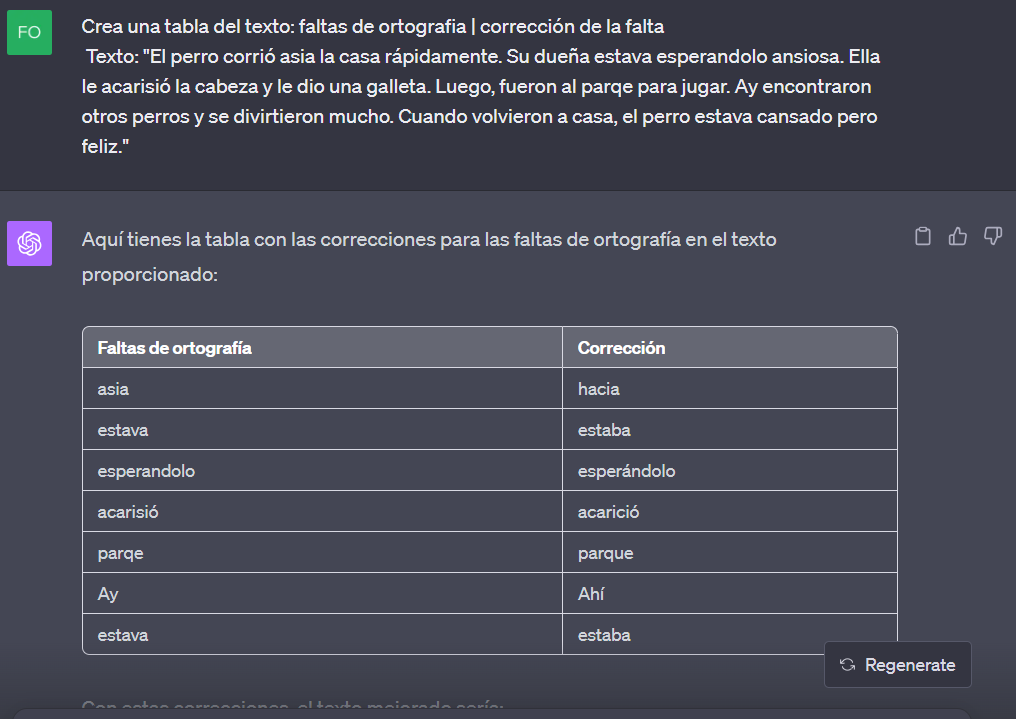

También se le puede solicitar que extraiga cierta información de un texto y la ordene en una tabla.

Para este ejemplo, vamos además a comprobar la capacidad del chatbot para corregir un texto con faltas de ortografía

Prompt: Crea una tabla extrayendo del texto: Concepto 1 | Concepto 2 | Concepto 3 Texto: [insertar texto]

A nivel mas avanzado, se le puede solicitar la generación de código con diferentes propósitos; crear una web, diseñar una app..

Fuente: https://profesoreco.blogspot.com/2023/04/instrucciones-precisas-y-potentes.html

Poner en unidad a parte: Actividad: Diseña Tu Propio Prompt

Instrucciones para crear un prompt efectivo para texto, imagen o audio

Ejercicio práctico para diseñar un prompt

Discusión y análisis de los resultados

Tiempo estimado: 30 minutos